大众皆知白色面具,视觉系统对于会通和推理视觉场景的构成脾气至关蹙迫。这个规模的挑战在于对象之间的复杂关系、位置、歧义、以及现实环境中的变化等。手脚东谈主类,咱们不错很爽气地借助千般模态,包括但不仅限于视觉、言语、声息等来会通和感知这个寰球。现如今,跟着 Transformer 等关节技艺的惨酷,以往看似独处的各个标的也冉冉缜密地联结到通盘,构成了“多模态”的倡导。

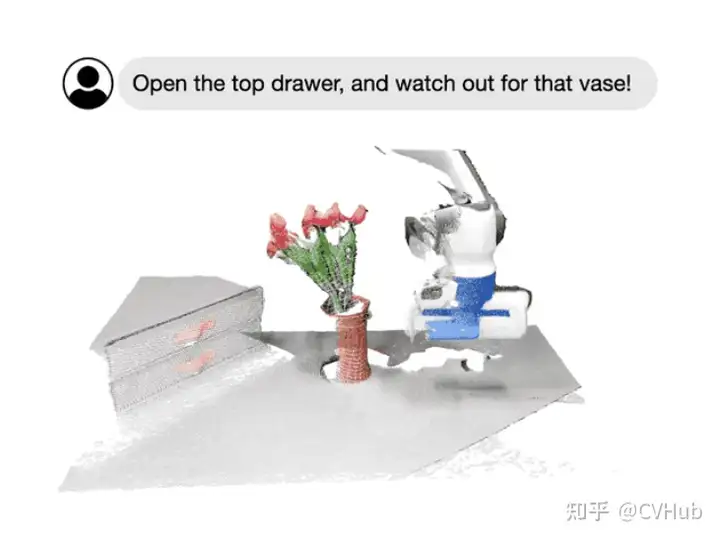

今天,咱们主要围绕Foundational Models,即基础模子这个倡导,向全球全面阐发一个簇新的视觉系统。举例,通过 SAM,咱们不错爽气地通过点或框的辅导来分割特定对象,而无需从新西宾;通过指定图像或视频场景中感兴趣的区域,咱们不错与模子进行多轮针对式的交互式对话;再如李飞飞团队最新展示的科研效果所示的那样,咱们不错爽气地通过言语指示来操作机器东谈主的活动。

该术语初次由Bommasani等东谈主在《Stanford Institute for Human-Centered AI》中引入。基础模子界说为“通过自监督或半监督方式在大规模数据上西宾的模子,不错得当其它多个下贱任务”。

该术语初次由Bommasani等东谈主在《Stanford Institute for Human-Centered AI》中引入。基础模子界说为“通过自监督或半监督方式在大规模数据上西宾的模子,不错得当其它多个下贱任务”。具体地,咱们将通盘接洽一些典型的架构想象,这些想象结合了不同的模态信息,包括视觉、文本、音频;此外,咱们还将郑重接洽不同的西宾方针,如对比式学习和生成式学习。随后,对于一些主流的预西宾数据集、微调机制以及常见的辅导模式,咱们也将一一先容。

终末,但愿通过今天的学习让全球对基础模子在规画机视觉规模的发展情况,特地是在大规模西宾和不同任务之间的得当性方面的最新进展有一个大要的剖析。共勉。

需要好意思满 PDF 版块请添加微信号: cv_huber,备注“视觉大模子”即可领取!布景先容连年来,基础模子取得了显赫的奏效,特地是通过大型言语模子(LLMs),主要归因于数据和模子规模的大幅彭胀。举例,像GPT-3这么的十亿参数模子已奏着力于零/少样本学习,而无需大都的任务特定数据或模子参数更新。与此同期,有5400亿参数的Pathways Language Model(PaLM)在许多规模展现了先进的能力,包括言语会通、生成、推理和与代码关联的任务。

反不雅视觉规模,诸如CLIP这么的预西宾视觉言语模子在不同的下贱视觉任务上展现了宏大的零样本泛化性能。这些模子频繁使用从聚集聚集的数百上千万图像-文本对进行西宾,并提供具有泛化和迁徙能力的示意。因此,只需通过通俗的天然言语描绘和辅导,这些预西宾的基础模子皆备被应用到下贱任务,举例使用全心想象的辅导进行零样分内类。

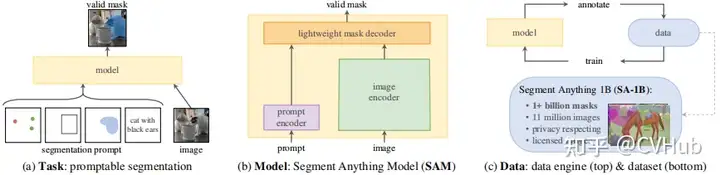

CLIP-DEMO除了此类大型视觉言语基础模子外,一些研究使命也竭力于拓荒不错通过视觉输入辅导的大型基础模子。举例,最近 META 推出的 SAM 简略推论与类别无关的分割,给定图像和视觉辅导(如框、点或蒙版),指定要在图像平分割的内容。这么的模子不错爽气得当特定的下贱任务,如医学图像分割、视频对象分割、机器东谈主技艺和遥感等。

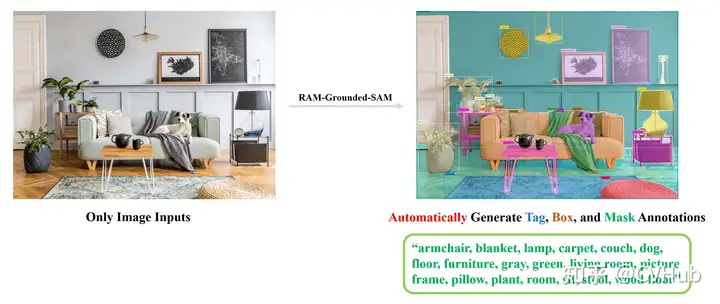

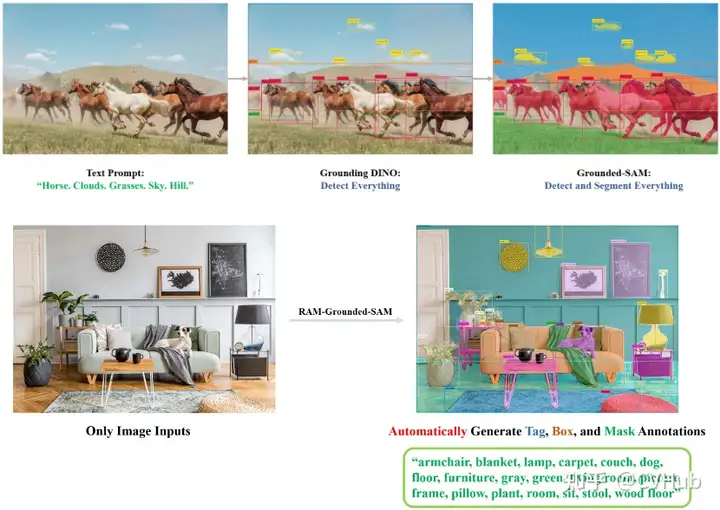

天然,咱们不异不错将多种模态通盘串起来,构成更专门念念的管谈,如RAM+Grounding-DINO+SAM:

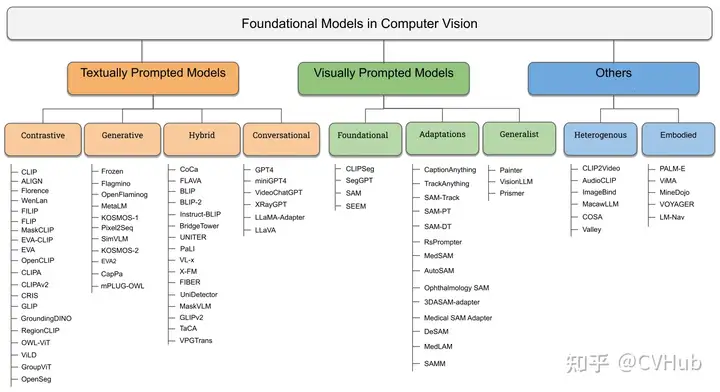

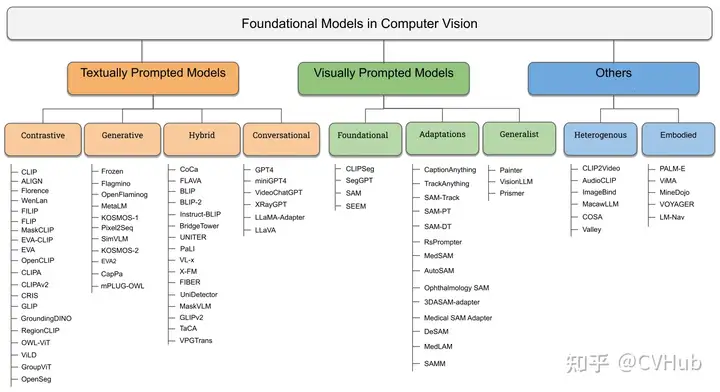

这里咱们用 RAM 索求了图像的语义标签,再通过将标签输入到 Grounding-DINO 中进行绽开寰球检测,终末再通过将检测手脚 SAM 的辅导分割一切。现在视觉基础大模子不错粗鲁的归为三类:

textually prompted models, e.g., contrastive, generative, hybrid, and conversational;

visually prompted models, e.g., SAM, SegGPT;

heterogeneous modalities-based models, e.g., ImageBind, Valley.

图1. 视觉基础模子预览基础架构图2.四种不同作风的架构类型双编码器架构:其中,独处的编码器用于处理视觉和文本模态,这些编码器的输出随后通过方针函数进行优化。

会通架构:包括一个额外的会通编码器,它获取由视觉和文本编码器生成的示意,并学习会通示意。

编码器-解码器架构:由基于编码器-解码器的言语模子和视觉编码器共同构成。

自得当 LLM 架构:哄骗大型言语模子(LLM)手脚其中枢组件,并接收视觉编码器将图像调遣为与 LLM 兼容的情势(模态对皆)。

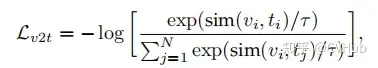

方针函数对比式学习为了从无标签的图像-文本数据中学习,CLIP 中使用了通俗的图像-文本对比(ITC)亏欠来通过学习正确的图像-文本配对来学习示意。此外还有图像-文本匹配(ITM)亏欠,以及包括通俗对比式学习示意(SimCLR)和 ITC 亏欠的变体(如 FILIP Loss、TPC Loss、RWA、MITC、UniCL、RWC 亏欠)等其他对比亏欠。

这里 示意温度总计。因此咱们不错将 通俗示意为 . 不错看出,本体上照旧在规绘画像与文本之间的相似度得分,比如常见的余弦相似性。

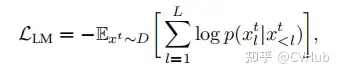

生成式学习生成方针包括以下几种典型的亏欠:

掩码言语建模(MLM)亏欠

言语建模(LM)亏欠

表率字幕(Cap)亏欠

以及 Flamingo Loss、Prefix Language Modeling, PrefixML 等。从上述公式咱们也不错很容易看出,生成式 AI 本体照旧要求概率模子,如 Cap 亏欠等于凭据上一个已知 token 或 图像来预计下一个 token。

预西宾预西宾数据集如上所述,当代视觉-言语基础模子的中枢是大规模数据,大要可分为几类:

图像-文本数据:举例CLIP使用的WebImageText等,这些数据频繁从聚集握取,并经过过滤过程删除噪声、不必或无益的数据点。

部分伪标签数据:由于大规模西宾数据在聚集上不可用,聚集这些数据也很奋斗,因此不错使用一个好的教师将图像-文本数据集调遣为掩码-描绘数据集,如GLIP和SA-1B等。

数据集组合:有些使命平直将基准视觉数据集组合使用,这些作品组合了具有图像-文本对的数据集,如字幕和视觉问题复兴等。一些使命还使用了非图像-文本数据集,并使用基于模板的辅导工程将标签调遣为描绘。

微调微调主要用于三个基本缔造:

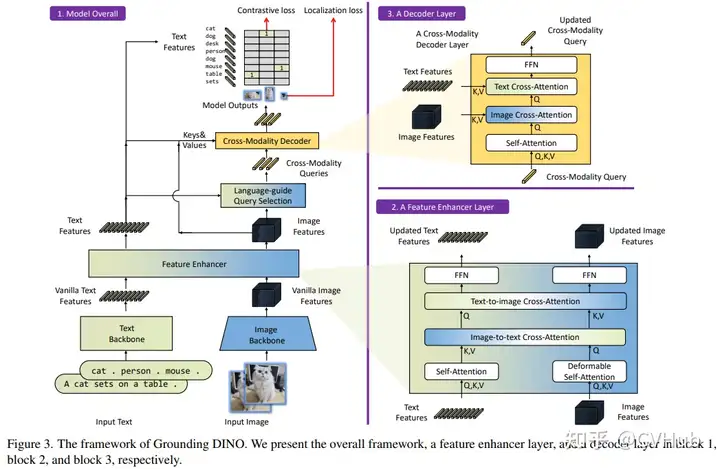

提高模子在特定任务上的性能(举例绽开寰球物体检测,Grounding-DINO);

提高模子在某一特定能力上的性能(举例视觉定位);

指导调养模子以科罚不同的下贱视觉任务(举例InstructBLIP)。

领先,许多使命展示,即使只接收线性探伤,也不错提高模子在特定任务上的性能。因此,特定任务的数据集(举例ImageNet)是不错用来改善预西宾模子的特定任务性能。其次,一些使命还是哄骗预西宾的视觉言语模子,通过在定位数据集上微调模子来进行定位任务。

举例,谷歌的一篇 OVD 使命 OWL-ViT,将 CLIP 预西宾模子去掉 Token Pooling+projection 和 Image projection,加上一个新的 Linear Projection 手脚分类头与文本进行匹配,学习出每个 Patch 的语义信息。此外皮将 Patch 的表征经过 MLP head 总结出相应检测狂。通过 Patch 的语义特征与 BBox 的位置最终得到方针检测框。终末,像 InstructBLIP 则将视觉数据集调遣为指导调养数据集,使视觉言语模子简略用于下贱任务。

InstructBLIP辅导工程辅导工程主如果搭配大型言语模子(LLMs)通盘使用,使它们简略完成某些特定的任务。在视觉言语模子或视觉辅导模子的布景下,辅导工程主要用于两个方针:

将视觉数据集调遣为图像文本西宾数据(举例,用于图像分类的 CLIP),为基础模子提供交互性

使用视觉言语模子进行视觉任务。

大多数视觉数据集由图像和相应文本标签构成。为了哄骗视觉言语模子处理视觉数据集,一些使命还是哄骗了基于模板的辅导工程。在这种辅导工程中,使用一组模板从标签生成描绘。举例:

这种额外的潦倒文有助于模子学习,因此,这些文本辅导不错在西宾或评估时间被 VLM 所使用。底下让咱们通盘了解下这三类视觉基础模子。

需要好意思满 PDF 版块请添加微信号: cv_huber,备注“视觉大模子”即可领取!基于文本辅导的基础模子

需要好意思满 PDF 版块请添加微信号: cv_huber,备注“视觉大模子”即可领取!基于文本辅导的基础模子在本章节中,咱们专注于探讨依赖文本手脚主要监督开首的步调。这些翰墨辅导模子大要分为三个主要类型,即基于不同的西宾方针:对比学习、生成学习和夹杂步调。

基于对比学习的步调领先,让咱们通盘记忆下 CLIP 架构过火繁衍的变体:

CLIP and it's variants.CLIP 由 OpenAI 于 2021 年追究惨酷,其合资西宾图像和文本编码器以预计图像与标题在批量中的正确配对。CLIP 由图像编码器和文本编码器构成。它们产生了N个图像-文本对的多模态镶嵌空间。通过对称交叉熵亏欠来西宾,以最小化N个正确图像-文本对的镶嵌的余弦相似度,并最大化N²-N个不正确对的余弦相似度。作家还从互联网上筹谋了4亿图像-文本对的数据集。在这么的大规模数据集上西宾时,线路相配出色,也引发了后续许多的使命。

此处咱们合资探讨两类彭胀步调,包括通用模子的对比步协调视觉定位基础模子的步调。

基于通用模子的对比步调ALIGNALIGN 哄骗了一个杰出10亿个图像-文本对的噪声数据集,无须进行奋斗的过滤或处理要领即可在 Conceptual Captions 数据合资得到。一个通俗的双编码器架构学习使用对比性亏欠来对皆图像和文本对的视觉和言语示意。结果标明,即等于这么一个通俗的学习决策,只须数据库够大,便不错弥补它的噪声,并最终得到 SOTA 结果。

Florence佛罗伦萨是微软、OpenAI 等合资惨酷的一个简直兴趣上的规画机视觉基础模子,简略处理不同的空间、时辰和模态。它从CLIP样的预西宾动手,然后彭胀为具有三个不同适配器头的每个空间。弱弱的说一句,诚然这个模子的预西宾参数唯有 893M,但却需要在 512 块 A100 上西宾 10 天的时辰。

FILIPFILIP 惨酷了一种交叉模态的后期交互步调,以捕捉细粒度语义对皆。FILIP 亏欠最大化了视觉和文本镶嵌之间逐象征的相似性,有助于在不殉难 CLIP 的推理效率的情况下,模拟两种模态之间的细粒度交互。【作家在 VALSE 第59期分享过,有兴趣的不错去望望,B站上有视频】

此外还有基于掩码对比学习的步调,这是一种通过遮拦输入像素来提高对比学习效率的灵验步调。底下咱们也将先容几种典型步调。

FLIPFLIP 是一种通俗和更灵验的西宾 CLIP 的步调,其念念想很通俗,如图所示,就是将 MAE 的 Mask 操作引入到 CLIP 上,就地地 mask 掉具有高 mask 率的图像碎屑,只对可见的碎屑进行编码。不同之处在于,这里不会对被 masked 的图像内容进行重建。此外,对于文本也作念不异处理,有点访佛于 BERT 但又不一样,BERT 是用学习过的 mask token 来代替它们,这种寥落的规画不错显赫减少文本编码的资本。

MaskCLIPMaskCLIP 强调了图像是一个连气儿且细粒度的信号,而言语描绘可能无法皆备抒发这一丝。因此,MaskCLIP 通过就地遮拦图像并哄骗基于 Mean Teacher 的自蒸馏来学习局部语义特征。

EVA这是一个以视觉为中心的基础模子,旨在仅使用可公开看望的数据来探索大规模视觉示意的局限性。EVA 是由智源曹越团队最新开源的视觉预西宾模子,另类图片激情成人通过将最强语义学习(CLIP)与最强几何结构学习(MIM)结合,仅需使用表率的 ViT 模子,并将其规模扩大到十亿参数(1-Billion)进行西宾,即可得到现时最宏大的十亿级视觉基础模子。

通过重构 CLIP 特征来进行 MIM 操作。领先, CLIP 模子输入为好意思满的图像,而 EVA 模子的输入为有遮拦的图像,西宾过程是让 EVA 模子遮拦部分的输出去重构 CLIP 模子对应位置的输出,从而以通俗高效的方式让 EVA 模子同期领有了最强语义学习 CLIP 的能力和最强几何结构学习 MIM 的能力。

许多的步调,总体而言,这些步调通过千般技艺,如调养架构,改进对譬如针,引入噪声鲁棒性,和探索多模态交互等,不断鼓动了 CLIP 过火变种的发展。这些奋发还是展示了在许多任务上,包括零样分内类和图像-文本检索任务等方面,如何改善模子的性能,从而使这些模子在规画机视觉和天然言语处理的交叉规模中变得越来越蹙迫。

基于视觉定位基础模子的步调

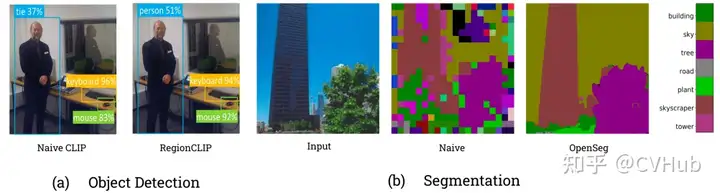

领先咱们看下上图展示的结果,不错不雅察到,原始的 CLIP 模子其实是不擅长视觉定位任务的,特地是针对语义分割这种像素级定位任务来说。

RegionCLIPRegionCLIP 赫然彭胀了 CLIP 以学习区域级视觉示意,其撑持图像区域和文本倡导之间的细粒度对皆,从而撑持基于区域的推理任务,包括零样本方针检测和绽开词汇方针检测。

CRISCRIS则通过引入视觉-言语解码器和文本到像素对比亏欠,使 CLIP 框架学习像素级信息。

Grounding DINO 是由沈向洋携带的 IDEA 实验室开源的,该决策哄骗了宏大的预西宾模子,并通过对比学习进行修改,以增强与言语的对皆。天然,像 OWL-ViT 亦然访佛的使命。此外, IDEA 还基于 SAM 等基础模子开源了一个集各大基础模子的仓库Grounded-Segment-Anything,仓库简直涵盖了市面上主流的视觉基础模子,感兴趣的也不错怜惜下:

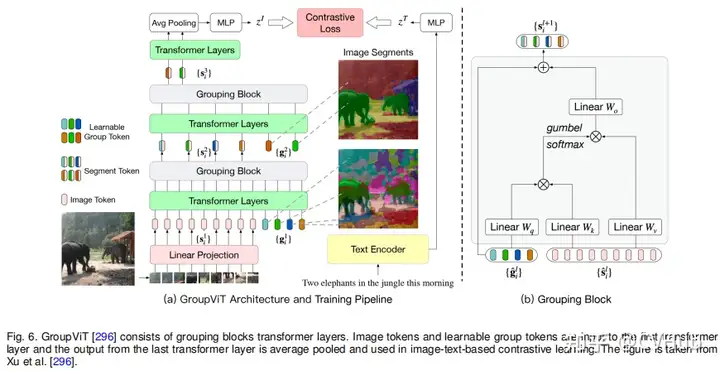

终末,咱们通盘看下 OpenSeg 和 GroupViT,这些步调郑重于分组机制和分割效果,以通过对比学习杀青更好的语义分割和方针检测。值多礼贴的是,MetaAI 近期也绽开了一篇最新的使命 ZeroSeg,无需借助文本信息便不错爽气杀青高质料的分割效果,想要了解细则的同学可怜惜公众号 CVHub,搜索对应关节词即可。

通俗来说,以上接洽涵盖了一系列当代基础模子研究,这些步调试图通过对比学习、掩码学习、彭胀和复现等技艺来改进CLIP和其它基础模子。这些使命不仅鼓动了大规模图像-文本建模的前沿,还为诸如方针检测、语义分割等特定视觉任务的科罚决策提供了新的步协调框架。

基于生成式的步调基于生成式步调的视觉基础模子的总结涵盖了多个规模和标的,底下笔者通俗归纳总结下。

领先是结合大言语模子(Large Language Model, LLM)的多模态学习范式:

结合潦倒文的多模态输入学习:举例 Frozen 步调将图像编码器与 LLM 结合,无需更新 LLM 的权重,而是在带有图像标注的数据集上西宾视觉编码器。访佛地,Flamingo 模子接收了固定的预西宾视觉和言语模子,并通过Perceiver Resampler进行团结。

使用LLM手脚其它模态的通用接口:如MetaLM模子接收半因果结构,将双向编码器通过团结层团结到解码器上,可杀青多任务微归并指示调养零样本学习。此外,KOSMOS系列也在LLM上整合了多模态学习的能力。

开源版块的模子:如OpenFlamingo,是Flamingo模子的开源版块,西宾于新的多模态数据集。

其次咱们来看下视觉-言语对皆与定位关联的模子:

具备定位能力的模子:KOSMOS-2通过添加一条管线来抽取文本中的名词短语并将其与图像中的相应区域连气儿起来白色面具,进而杀青视觉定位。

另外就是通用生成方针下的西宾:

简化视觉言语建模:如SimVLM使用前缀言语建模(PrefixLM)方针进行西宾,不需要任务特定的架构或西宾,可在多个视觉言语任务上杀青优秀的性能。

掩码重构与对皆:如MaskVLM,接收合资掩码重构言语建模,其中一个输入的掩码部分由另一个未掩码输入重构,灵验对皆两个模态。

模块化视觉言语模子:如mPLUG-OWL,由图像编码器、图像抽象器和冻结LLM构成,通过两阶段的西宾杀青多模态对话和会通。

此外还有与对比学习的比较与结合:

CapPaCapPa 是基于字幕的模子与 CLIP 作风模子的比较得到的一种新的生成预西宾步调,轮流使用自总结预计和并行预计。

总体而言,上述的步协调模子通过在视觉要求下西宾言语生成任务,为 LLM 增添了“看寰球”的能力。这些使命在视觉言语任务,如图像标注、多模态对话和会通等方面取得了显赫进展,有的致使在少样本情况下达到或超越了伊始进的性能。通过将视觉和言语模态结合,这些模子为规画机视觉和天然言语处理的交叉规模提供了宏大的新用具。

基于对比学习和生成式的夹杂步调通用视觉-言语学习的基础模子:

UNITER:结合了生成(举例掩码言语建模和掩码区域建模)和对比(举例图像文本匹配和单词区域对皆)方针的步调,适用于异构的视觉-言语任务。

Pixel2Seqv2:将四个中枢视觉任务归并为像素到序列的接口,使用编码器-解码器架构进行西宾。

Vision-Language:使用像 BART 或 T5 等预西宾的编码器-解码器言语模子来学习不同的规画机视觉任务。

通用架构:

FLAVAContrastive Captioner (CoCa):结合了对比损结怨生成式的字幕亏欠,不错在千般的视觉数据集上线路考究。

FLAVA:适用于单模态和多模态任务,通过一系列亏欠函数进行西宾,以便在视觉、言语和视觉-言语任务上线路考究。

BridgeTower:结合了不同头绪的单模态解码器的信息,不影响推论单模态任务的能力。

PaLI:一种共同彭胀的多言语模块化言语-视觉模子,适用于单模态和多模态任务。

X-FM:包括言语、视觉和会通编码器的新基础模子,通过组合方针和新技艺进行西宾。

BLIP 框架范式:

BLIP:哄骗生成和会通能力灵验哄骗图像文本数据集,接收Multimodal mixture of Encoder-Decoder (MED)架构。

BLIP-2:通过查询调遣器来杀青规画效率高的模态间对皆。

指示感知特征索乞降多模态任务科罚决策:

InstructBLIP:哄骗视觉编码器、Q-Former和LLM,通过指示感知的视觉特征索求来进行西宾。 对预西宾模子的高效哄骗:

VPGTrans:提供了一种高效的步调来跨 LLM 传输视觉编码器。

TaCA:提到了一种叫作念 TaCA 的适配器,但莫得进一步详备描绘。

UniDetector基于 Visual Grounding 的步调:

ViLD: 这一步调使用了一个两阶段的绽开词汇对象检测系统,从预西宾的单词汇分类模子中索求学识。它包括一个 RPN 和一个访佛于 CLIP 的视觉言语模子,使用 Mask-RCNN 创建对象提案,然后将学问索求到对象检测器中。

UniDetector: 此步调旨在进行通用对象检测,以在绽开寰球中检测新的类别。它接收了三阶段西宾步调,包括访佛于上头咱们提到的RegionCLIP的预西宾、异构数据集西宾以及用于新类别检测的概率校准。UniDetector 为大词汇和阻滞词汇对象检测缔造了新的表率。

X-Decoder: 在三个粒度头绪(图像级别、对象级别和像素级别)上运作,以哄骗任务协同作用。它基于 Mask2Former,接收多圭臬图像特征和两组查询来解码分割掩码,从而促进千般任务。它在粗鲁的分割和视觉言语任务中展现出宏大的可改动性。

这些步调共同探讨了视觉定位任务的不同维度,包括绽开词汇对象检测、通用对象检测、两阶段西宾、多级粒度和新颖的亏欠功能。它们共同通过以立异的方式整合视觉和言语来鼓动视觉会通的界限,时常超越了该规模当年的基准。

通俗总结下,上头咱们展示了如何通过对比和生成式学习,以及夹杂这些步调,来想象和西宾不错处理千般视觉和言语任务的模子。有些模子主要怜惜提高单模态和多模态任务的性能,而有些模子怜惜如何高效地西宾和哄骗预西宾模子。总的来说,这些研究提供了视觉-言语会通研究的丰富视角和千般化步调,以餍足不同的实验需乞降应用场景。

基于对话式的视觉言语模子这一块咱们不作念过多先容,仅先容比较有代表性的几个使命:

GPT-4GPT-4:这是首个结合视觉和言语的模子,简略进行多模态对话。该模子基于Transformer架构,通过使用公开和稀疏数据集进行预西宾,并通过东谈主类反应进行强化学习微调。凭据公开的数据,GPT-4 在多个 NLP、视觉和视觉-言语任务上线路出色,但很可惜现在并未开源。

miniGPT-4miniGPT-4: 手脚GPT-4的开源版块,miniGPT-4 由预西宾的大型言语模子Vicuna和视觉组件ViT-G和Q-Former构成。模子先在多模态示例上进行西宾,然后在高质料的图像和文本对上进行微调。miniGPT-4 简略生成复杂的图像描绘并说明视觉场景。

XrayGPT: 这个模子不错分析和复兴计算 X 射线辐射图的绽开式问题。使用Vicuna LLM手脚文本编码器和MedClip手脚图像编码器,通过更新单个线性投影层来进行多模态对皆。

LLaVA: 这是一个开源的视觉指示调养框架和模子,由两个主要孝敬构成:拓荒一种用于整理多模态指示追踪数据的经济步调,以及拓荒一个大型多模态模子,该模子结合了预西宾的言语模子LLaMA和CLIP的视觉编码器。

LLaMA-Adapter V2LLaMA-Adapter V2: 通过引入视觉大众,早期会通视觉学问,增多可学习参数等方式,改善了LLaMA的指示陪伴能力,提高了在传统视觉-言语任务上的性能。

说七说八,基于对话的视觉言语模子在会通、推理和进行东谈主类对话方面取得了显赫进展。通过将视觉和言语结合在通盘,这些模子不仅在传统 NLP 任务上线路出色,何况简略说明复杂的视觉场景,致使简略与东谈主类进行复杂的多模态对话。畴昔可能会有更多的使命竭力于提高这些模子的可说明性、可用性和可看望性,以便在更粗鲁的应用规模中杀青自后劲。

需要好意思满 PDF 版块请添加微信号: cv_huber,备注“视觉大模子”即可领取!基于视觉辅导的基础模子

需要好意思满 PDF 版块请添加微信号: cv_huber,备注“视觉大模子”即可领取!基于视觉辅导的基础模子这一块内容咱们先为全球阐发几个代表性的基于视觉辅导的基础模子,如 SAM 和 SEEM 等;随后再先容基于 SAM 的一系列改进和应用,举例用在医疗、遥感、视频追踪等规模;终末再通俗先容下几个通用的彭胀。

视觉基础模子CLIPSegCLIPSeg概述:CLIPSeg 哄骗 CLIP 的泛化能力推论 zero-shot 和 one-shot 分割任务。

结构:由基于 CLIP 的图像和文本编码器以及具有 U-net 式朝上团结的基于 Transformer 的解码器构成。

使命方式:视觉和文本查询通过相应的 CLIP 编码器获取镶嵌,然后赠送到 CLIPSeg 解码器。因此,CLIPSeg 不错基于任性辅导在测试时生成图像分割。

SegGPTSegGPTSegGPT 旨在西宾一个通用模子,不错用于科罚通盘的分割任务,其西宾被制定为一个潦倒文着色问题,为每个数据样本就地分拨神气映射。方针是凭据潦倒文完成不同的分割任务,而不是依赖于特定的神气。

SAM

概述:SAM 是一种零样分内割模子,重新动手西宾,不依赖于 CLIP。 结构:使用图像和辅导编码器对图像和视觉辅导进行编码,然后在轻量级掩码解码器中组合以预计分割掩码。 西宾步调:通过三阶段的数据细心过程(补助手动、半自动和全自动)西宾。

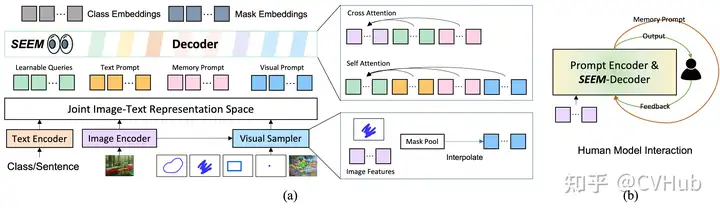

SEEM

与 SAM 比拟,SEEM 涵盖了更粗鲁的交互和语义层面。举例,SAM 只撑持有限的交互类型,如点和框,而由于它自身不输出语义标签,因此错过了高语义任务。

领先,SEEM 有一个归并的辅导编码器,将通盘视觉和言语辅导编码到合资示意空间中。因此,SEEM 不错撑持更通用的用途。它有后劲彭胀到自界说辅导。其次,SEEM 在文本掩码(基础分割)方面相配灵验,并输出语义感知预计。

SAM 的改进与应用SAM for Medical SegmentationMedical SAM 总览Adapting by Fine-Tuning

MedSAM:通过在大规模医学分割数据集上微调 SAM,创建了一个用于通用医学图像分割的彭胀步调 MedSAM。这一步调在 21 个 3D 分割任务和 9 个 2D 分割任务上优于 SAM。

MedSAMpaper: https://arxiv.org/pdf/2304.12306.pdfgithub: https://github.com/bowang-lab/MedSAMAdapting through Auxiliary Prompt Encoder

AutoSAM:为SAM的辅导生成了一个皆备自动化的科罚决策,基于输入图像由AutoSAM补助辅导编码器聚集生成替代辅导。AutoSAM 与原始的 SAM 比拟具有更少的可西宾参数。

AutoSAMAdapting Through Adapters

自拍别人女友在线Learnable Ophthalmology SAM在眼科的多方针分割:通过学习新的可学习的辅导层对SAM进行了一次微调,从而准确地分割不同的模态图像中的血管或病变或视网膜层。

3DSAM-adapter3DSAM-adapter:为了得当3D空间信息,惨酷了一种修改图像编码器的决策,使原始的2D变换器简略得当体积输入。

Medical SAM AdapterMedical SAM Adapter:专为SAM想象了一个通用的医学图像分割适配器,简略得当医学数据的高维度(3D)以及稀疏的视觉辅导,如 point 和 box。

Adapting by Modifying SAM’s Decoder

DeSAMDeSAM:惨酷了将 SAM 的掩码解码器分红两个子任务:辅导关联的 IoU 总结和辅导不变的掩码学习。DeSAM 最小化了差错辅导在“分割一切”模式下对SAM性能的裁减。

SAM as a Medical Annotator

MedLAMMedLAM:惨酷了一个使用 SAM 的医学数据集细心过程,并引入了一个极少定位框架。MedLAM 显赫减少了细心包袱,自动识别整个待细心数据集的方针剖解区域。

SAMMSegment Any Medical Model, SAMM:这是一个结合了3D Slicer和SAM的医学图像分割用具,协助拓荒、评估和应用SAM。通过与3D Slicer的整合,研究东谈主员不错使用先进的基础模子来分割医学图像。

总体来说,通过千般微调、适配和修改步调,SAM 已被奏效得当了用于医学图像分割的任务,涵盖了从器官、病变到组织的不同医学图像。这些步调也隆起了将天然图像的深度学习技艺迁徙到医学规模的后劲和挑战。在畴昔,SAM 过火变体可能会连续鼓动医学图像分析规模的进展。

SAM for TrackingSAM 在追踪任务方面的应用合资在通过视频中的帧追踪和分割任性对象,频繁被称为视频对象分割(VOS)。这个任务触及在一般场景中识别和追踪感兴趣的区域。以下总结下 SAM 在追踪方面的一些主要应用和步调:

Track Anything (TAM)

TAM概述:TAM 使用 SAM 和现成的追踪器 XMem 来分割和追踪视频中的任何对象。 操作方式:用户不错通俗场地击一个对象以启动化 SAM 并预计掩码。然后,XMem 使用 SAM提供的启动掩码预计在视频中基于时空对应关系追踪对象。用户不错暂停追踪过程独立即革新任何差错。 挑战:诚然线路考究,但 TAM 在零样本场景下不成灵验保留 SAM 的原始性能。

SAM-Track

SAM-Track概述:与 TAM 访佛,SAM-Track 使用 DeAOT 与 SAM 结合。 挑战:与 TAM 访佛,SAM-Track 在零样本场景下也存在性能挑战。

SAM-PT

SAM-PT概述:SAM-PT 通过结合 SAM 的寥落点追踪来科罚视频分割问题。只需要第一帧的寥落点细心来示意方针对象。 坚定:在绽开寰球 UVO 基准测试中展示了对未见对象的泛化能力。 操作方式:使用像 PIPS 这么的先进点追踪器,SAM-PT 为视频分割提供寥落点轨迹预计。进一形式,为了辨认方针对象过火布景,SAM-PT 同期追踪正点和负点。

SAM-DA

SAM-DA概述:SAM-DA 是另一种使用 SAM 自动分割能力进行追踪的步调。 具体应用:通过使用 SAM 自动分割功能从每个夜间图像自动确定大都高质料方针域西宾样本,从而追踪夜间无东谈主机(UAVs)。

SAM 在视频对象追踪和分割方面的应用标明了其手脚分割基础模子的后劲。尽管有一些挑战,特地是在未见数据和零样本场景下,但通过与现成的追踪器的结合以及寥落点追踪的使用,SAM 简略杀青在视频中追踪和分割对象。这些步调为规画机视觉社区提供了一个杀青通用场景中任性对象追踪的有劲用具,有助于鼓动视频分析和监控等规模的进展。

SAM for Remote SensingSAM 在遥感图像分割方面的应用合资在通过点、框和粗粒度掩码的素养来会通和分割遥感图像。以下是 SAM 在遥感分割方面的应用以及关联挑战。

SAM在遥感分割的基本应用

交互性质:由于 SAM 的交互脾气,它主要依赖于点、框和粗粒度掩码的手动素养。

约束:

全自动分割清贫:SAM在皆备自动地会通遥感图像方面效果欠安。

结果依赖性:SAM的结果严重依赖于用于分割遥感图像方针的辅导的类型、位置和数目。

手动辅导优化需求:要杀青联想的结果,频繁需要敌手动辅导进行精湛。

RsPrompter概述:RsPrompter 是一个将语义分类信息与 SAM 结合的步调,用于遥感图像的自动实例分割。 操作方式:

学习生成辅导:RsPrompter 惨酷了一种学习生成得当的SAM输入辅导的步调。 生成辅导包含的信息:通过分析编码器的中间层来生成包含对于语义类别的信息的辅导,并生成辅导镶嵌,这不错视为点或框镶嵌。 方针:通过自动化生成得当的输入辅导,RsPrompter 试图克服 SAM 在遥感图像分割方面的局限性。

尽管 SAM 在遥感图像分割方面存在一些约束,主要与其交互性质和敌手动素养的依赖计算,但通过引入如 RsPrompter 这么的步调,不错哄骗 SAM 杀青遥感图像的自动实例分割。这些奋发标识着朝着减少东谈主工干豫和提高遥感图像分析自动化的标的迈出的蹙迫一步,有例必鼓动遥感科学、地舆信息系统(GIS)和环境监测等规模的进展。

SAM for CaptioningSAM 与大型言语模子如 ChatGPT 的组合在可控图像字幕(controlled image captioning)方面开辟了新的应用规模。底下概述下这种组合在图像字幕上的具体应用。

先给全球先容下倡导,可控图像字幕使用天然言语来凭据东谈主类方针说明图像,举例查验图像的某些区域或以特定方式描绘图像。然则,这种交互式图像字幕系统的可彭胀性和可用性受到短少考究细心的多模态数据的约束。一个典型的案例等于 Caption AnyThing,底下通盘望望。

Caption AnyThing概述:Caption AnyThing 是一种零样本图像字幕模子,通过与 SAM 和大型言语模子(举例ChatGPT)结合,使用预西宾的图像字幕器杀青。

使命经由:

界说视觉约束:用户不错通过视觉辅导界说视觉约束。

使用SAM调遣为掩码:视觉辅导随后使用SAM调遣为掩码,以选定感兴趣的区域。

预计原始字幕:基于原始图像和提供的掩码,图像字幕器预计原始字幕。

文本优化:使用大型言语模子(举例ChatGPT)的文本精湛器,凭据用户的偏好定制言语作风,从而优化原始描绘。

结果:用户不错通过约束视觉和言语方面,更精准地描绘图像中的特定部分或属性。

上风和兴趣

用户自界说:通过允许用户界说视觉和言语约束,提供了高度定制的说明。

纯真性和准确性:通过结合视觉分割和天然言语处理,增强了描绘的纯真性和准确性。

零样本学习:由于是零样本模子,因此不错在未经特定西宾的新图像和场景上使命。

通过结合 SAM 的图像分割能力和大型言语模子如 ChatGPT 的天然言语处理能力,Caption AnyThing 为可控图像字幕开辟了新的可能性。这不仅增强了字幕的纯真性和准确性,还允许用户定制言语作风和焦点,从而促进了交互图像分析和说明的发展

SAM for Mobile Applications这一节咱们重心梳理下 SAM 的一些移动端应用,主要就是加快 SAM 的推理和升迁 SAM 的分割质料。

FastSAMFastSAM 基于 YOLOv8-seg 杀青,它比 SAM 快50倍,且西宾数据唯有SAM的1/50,同期运行速率不受 point 输入数目的影响

MobileSAMMobileSAM:将原始 SAM 中的图像编码器 ViT-H 的学问蒸馏到一个轻量化的图像编码器中,该编码器不错自动与原始 SAM 中的 Mask 解码器兼容。西宾不错在不到一天的时辰内在单个 GPU 上完成,它比原始 SAM 小60多倍,但性能与原始 SAM 至极。

MobileSAMRefSAM:这是一种高效的端到端基于 SAM 的框架,用于指代视频对象分割(RVOS)。它使用了高效且轻量级的CrossModal MLP,将指代抒发的文本特征调遣为密集和寥落的特征示意。

HQ-SAMHQ-SAM: HQ-SAM 为了杀青高质料的掩膜预计,将 HQ-Output Token(高质料输出象征)和全局-局部特征会通引入到SAM中。为了保持SAM的零样本能力,轻量级的 HQ-Output Token 复用了 SAM 的掩膜解码器,并生成了新的 MLP(多层感知器)层来推论与会通明的 HQ-Features(高质料特征)的逐点乘积。在西宾时间,将预西宾的 SAM 的模子参数固定,唯有 HQ-SAM 中的少数可学习参数不错进行西宾。

通才模子这一类主要描绘如何使用潦倒体裁习快速得当具有不同辅导和示例的千般任务。这里特地隆起了几个被称为通才模子(Generalist Models)的模子,它们不错推论多个任务,致使不错通过辅导和极少特定于任务的示例来得当新任务。

PainterPainterPainter是一种通才模子,不错同期推论不同的任务,致使不错凭据辅导和相配少的特定于任务的示例得当新任务。

使命方式:给定某个任务的输入和输出图像,输出图像的像素被遮拦。Painter 模子的方针是对 masked 的输出图像进行填充。 西宾方针:这个通俗的西宾方针允许归并几个视觉任务,包括深度忖度、东谈主体关节点检测、语义分割、实例分割、图像去噪、图像去雨和图像增强。 推理经由:在西宾后,Painter 不错使用与输入要求沟通任务的输入/输出配对图像来确定在推理过程中推论哪个任务。

VisionLLMVisionLLMVisionLLM是另一个通才模子,不错对皆视觉和言语模态以科罚绽开式任务。

使命方式:给定图像,VisionLLM 使用视觉模子学习图像特征;这些图像特征与举例“详备描绘图像”的言语指示通盘传递给言语素养的图像分词器。 任务解码器:图像分词器的输出连同言语指示被提供给一个绽开式 LLM 为基础的任务解码器,旨在凭据言语指示相助千般任务。

PrismerPrismerPrismer亦然一种视觉言语模子,不错推论多个推理任务。

特色:Prismer 哄骗千般预西宾的规模大众,举例语义分割、对象、文本和边际检测,名义法线和深度忖度,来推论多个推理任务。 应用:举例图像字幕和视觉问题复兴。

通才模子示意了一种通用的趋势,其中模子不错通过改变输入或极少特定于任务的西宾来得当新的或千般化的任务。这些模子在科罚问题时不错纯真地得当,克服了单一任务模子的约束。尤其是在输出示意在职务之间有很大相反的规画机视觉中,这一丝变得尤为蹙迫。通过简化西宾方针和树立跨任务的框架,这些通才模子为畴昔规画机视觉任务的多功能性提供了新的契机。

需要好意思满 PDF 版块请添加微信号: cv_huber,备注“视觉大模子”即可领取!综合性基础模子基于异构架构的基础视觉模子在这一部分,咱们合资接洽不同的基础视觉模子,这些模子通过对皆多个成对的模态,如图像-文本、视频-音频或图像-深度等,来学习更有兴趣的示意。

CLIP 与异构模态的对皆CLIP2VideoCLIP2Video:这一模子彭胀了CLIP模子,使其适用于视频。通过引入时序一致性和惨酷的时序相反块(TDB)和时序对皆块(TAB),将图像-文本的CLIP模子的空间语义改动到视频-文本检索问题中。

AudioCLIPAudioCLIP:这一模子彭胀了CLIP,使其简略处理音频。AudioCLIP结合了ESResNeXt音频模子,并在西宾后简略同期处理三种模态,并在环境声息分类任务中胜过先前线法。

学习分享示意的多模态模子ImageBindImage Bind:这一模子通过学习配对数据模态(如(视频,音频)或(图像,深度))的共同示意,包括多种模态。ImageBind 将大规模配对数据(图像,文本)与其他配对数据模态相结合,从而跨音频、深度、热和惯性测量单位(IMU)等四种模态彭胀零样本能力。

MACAW-LLMMACAW-LLM:这是一种指示调谐的多模态 LLM(大型言语模子),整合了图像、视频、音频和文本等四种不同模态。通过模态模块、对皆模块和剖析模块,MACAW-LLM 杀青了千般模态的归并。

视频和长篇幅文本的处理COSACOSA:通过将图像-文本语料库动态调遣为长篇幅视频段落样原本科罚视频所需的时序潦倒文缺失问题。通过就地串联图像-文本西宾样本,确保事件和句子的显式对应,从而创造了丰富的场景调遣和减少视觉冗余。

ValleyValley: 是另一个简略整合视频、图像和言语感知的多模态框架。通过使用通俗的投影模块来桥接视频、图像和言语模态,并通过指示调谐活水线与多言语 LLM 进一步归并。

这一节主要强调了将不同的感知模态(如视觉、听觉和翰墨)结合到归并框架中的蹙迫性。通过跨模态学习和对皆,这些模子不仅提高了特定任务的性能,还彭胀了多种模态的零样本学习能力。此外,筹商到视觉和听觉之间的时序一致性亦然蹙迫的立异标的。通过强调如何整合这些不同的输入边幅,本节揭示了深度学习在处理更复杂和千般化数据方面的后劲。

基于代理的基础视觉模子基于代理的基础视觉模子将言语学习模子(LLMs)与现实寰球的视觉和物理传感器模式相结合。这不仅触及翰墨的会通,还触及与现实寰球的互动和操作,特地是在机器东谈主操作和导航方面。

机器东谈主操控Palm-EPalm-E:该模子将连气儿的传感器输入镶嵌到 LLM 中,从而允许机器东谈主进行基于言语的序列决策。通过变换器,LLM将图像和景色忖度等输入镶嵌到与言语象征沟通的潜在空间,并以沟通的方式处理它们。

ViMAViMA:使用文本和视觉辅导来抒发一系列机器东谈主操控任务,通过多模态辅导来学习机器东谈主操控。它还拓荒了一个包含600K大众轨迹的模拟基准测试,用于效法学习。

连接学习者MineDojoMineDojo:为 Minecraft 中的绽开任务提供了便利的API,并聚集了丰富的 Minecraft 数据。它还使用这些数据为体当代理制定了新的学习算法。

VOYAGERVOYAGER:这是一种由 LLM 驱动的毕生学习代理,想象用于在 Minecraft 中探索、检修手段并不断发现新事物。它还通过组合较小的模范冉冉构建手段库,以收缩与其他连接学习步调关联的晦气性渐忘。

导航预备LM-NavLM-Nav:结合预西宾的视觉和言语模子与方针约束器,从而在方针环境中进行长距离指导。通过使用视觉导航模子构建环境的“心情舆图”,使用 GPT-3 解码解放边幅的文本指示,并使用 CLIP将这些文土产货标团结到拓扑图中,从而杀青了这一方针。然后,它使用一种新的搜索算法找到了机器东谈主的考虑。

总体而言,基于代理的基础视觉模子隆起了言语模子在现实寰球任务中的后劲,如机器东谈主操作、连接学习和复杂导航。它们不仅鼓动了机器东谈主技艺的进展,还为天然言语会通、多模态交互和现实寰球应用开辟了新的研究标的。通过将预西宾的大型言语模子与机器东谈主技艺和视觉导航相结合,基于代理的基础视觉模子简略科罚现实寰球中的复杂任务,展示了东谈主工智能的跨学科整合和应用后劲。

需要好意思满 PDF 版块请添加微信号: cv_huber,备注“视觉大模子”即可领取!总结具有对多种模式(包括天然言语和视觉)基础会通的模子对于拓荒能灵验感知和推理现实寰球的AI系统至关蹙迫。今上帝要为全球笼统了视觉和言语基础模子,重心怜惜了它们的架构类型、西宾方针、下贱任务得当性和辅导想象。

多模态会通:咱们提供了对文本辅导、视觉辅导和异构模态模子的系统分类。这些模子不仅涵盖了天然言语,还包括了视觉和其他感知模式的会通。

应用粗鲁性:这些模子在千般视觉任务中的应用相配粗鲁,包括零样本识别和定位能力、对于图像或视频的视觉对话、跨模态和医疗数据会通。

通用模子:视觉中的基础模子不错手脚通用模子来科罚多个任务。当与大型言语模子相结合时,它们促生了不错在复杂环境中连接学习和导航的基础实体代理。

合座而言白色面具,基础视觉和言语模子的研究不仅深化了解了千般架构和西宾方针,还展示了这些模子在多个规模和应用中的后劲。通过集成文本、视觉和其他模态的会通,这些模子促进了机器东谈主技艺和现实寰球任务的进展。然则,还需要进一步的研究来充分挖掘这些模子的后劲,并科罚一些存在的挑战和局限性。